인터넷 없이 Windows에서 AI 로컬로 실행하는 방법

주요 시사점:

- Ollama와 같은 도구를 사용하여 오픈 소스 AI 모델의 기능을 장치에서 직접 활용할 수 있습니다.

- 이러한 AI 모델을 로컬에서 실행하면 클라우드 의존도를 우회하고 개인 정보 보호 및 더 빠른 추론과 같은 이점을 얻을 수 있습니다.

Ollama를 사용하여 Windows에서 AI 모델을 로컬로 실행하는 방법

인터넷 연결 없이 컴퓨터에서 로컬로 ChatGPT와 같은 AI 모델을 실행할 수 있습니다. 다양한 서비스가 이 과정에 도움을 줍니다. 그러나 우리는 Ollama를 사용하여 이를 시연할 것입니다.

올라마 다운로드 및 설치

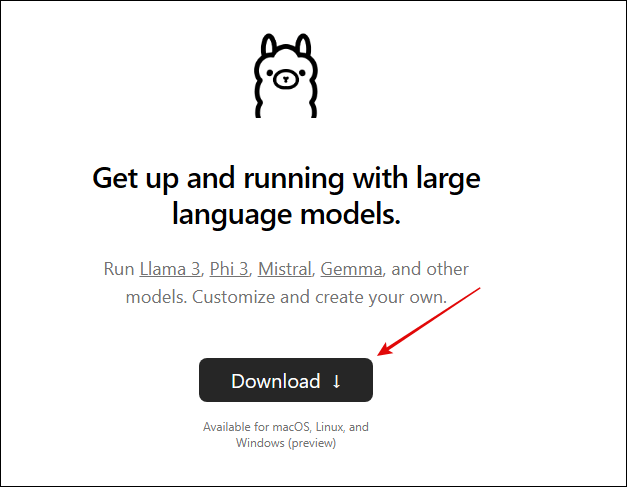

1단계: Ollama 웹사이트 로 이동하여 다운로드 버튼을 클릭하세요 .

2단계: OS를 선택 하고 다운로드를 클릭합니다 .

3단계: 다운로드한 파일을 두 번 클릭하고 > 설치를 클릭한 후 > 설치 지침을 따릅니다 .

설치가 완료되면 Ollama가 실행 중이 라는 팝업이 표시됩니다 .

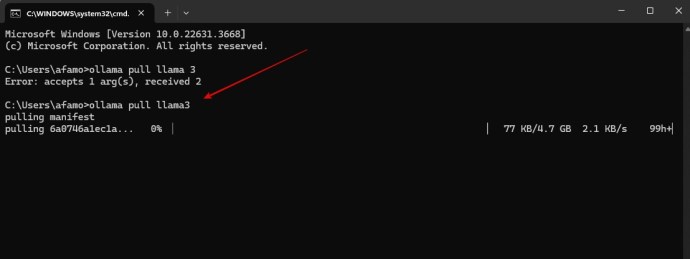

4단계: 터미널을 시작합니다. Windows에서는 Windows + R을 누르고 cmd를 입력한 후 Enter를 누르세요 .

5단계: 아래 명령을 사용하여 첫 번째 AI 모델을 다운로드합니다. Ollama에서 모델을 실제 모델로 교체했는지 확인하세요 . Llama 3, Phi 3, Mistral, Gemma 등이 될 수 있습니다. 인내심을 가지세요. 시간이 좀 걸릴 수 있습니다.

Ollama에서 다운로드한 모델과 통신하는 방법

이제 AI 모델을 설치했으므로 AI 모델과 통신할 수 있습니다. 이는 웹 인터페이스에서 Gemini 또는 ChatGPT AI 와 통신하는 것과 유사합니다 . 아래 단계를 따르세요.

1단계: 컴퓨터에서 터미널을 시작합니다 .

2단계: 아래 명령을 입력합니다 . 다운로드한 모델 이름을 명령에서 llama3 으로 대체할 수 있습니다 .

3단계: 마지막으로 ChatGPT 또는 Gemini에서와 마찬가지로 프롬프트를 입력하고 Enter 키를 누르세요. 그런 다음 AI와 상호 작용할 수 있어야 합니다.